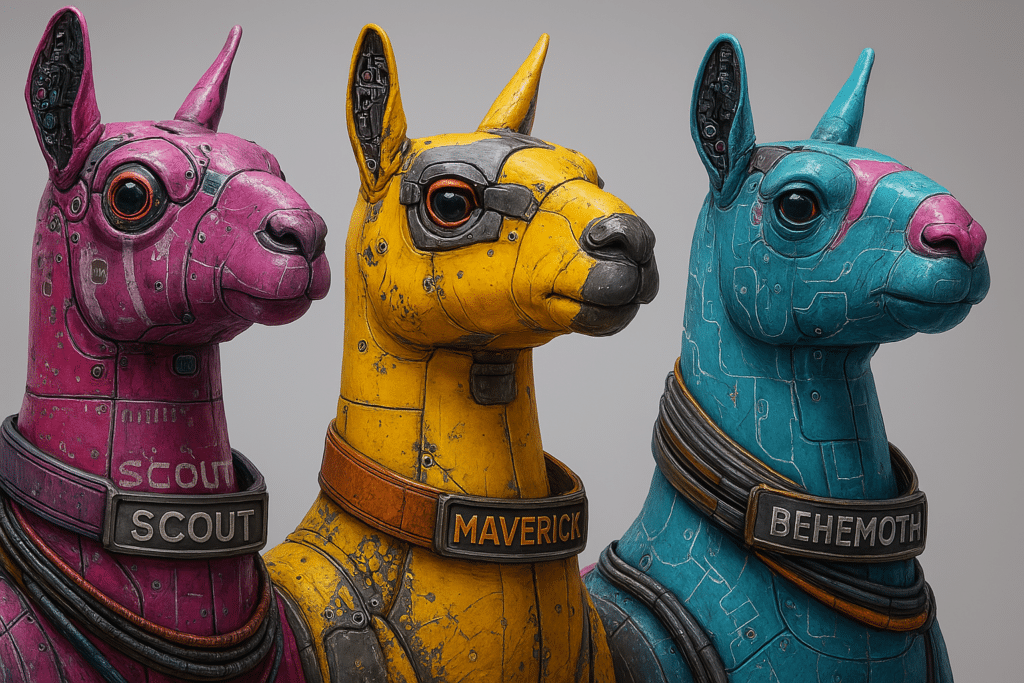

La course à l’intelligence artificielle générative s’accélère, avec les géants de la tech qui dévoilent successivement des modèles toujours plus puissants. Meta vient de lancer Llama 4, son nouveau modèle d’IA qui utilise une architecture Mixture-of-Experts (MoE) pour activer seulement une partie de ses milliards de paramètres lors de chaque requête. Avec ses variantes Scout et Maverick offrant un contexte de plusieurs millions de tokens, Llama 4 défie GPT-4 d’OpenAI et Gemini de Google sur les benchmarks de référence.

L’architecture MoE de Llama 4 permet d’obtenir des performances exceptionnelles tout en réduisant considérablement les ressources computationnelles requises. Trois variantes composent cette famille : Scout avec 17 milliards de paramètres actifs et 16 experts, Maverick également avec 17 milliards de paramètres, mais 128 experts, et Behemoth, le titan du groupe, atteignant 288 milliards de paramètres actifs. Cette approche révolutionnaire divise les tâches en sous-problèmes pour une efficacité énergétique inédite face aux modèles denses traditionnels.

Spécifications techniques et architecture de Llama 4

L’architecture Mixture-of-Experts représente la grande innovation technique de Meta Llama 4. Ce système divise intelligemment les tâches en sous-problèmes pour activer uniquement les parties pertinentes du modèle. Chaque variante possède un nombre d’experts distinct qui influence directement ses performances et son efficacité énergétique.

Les modèles Llama 4 se distinguent par leur gestion optimisée des paramètres. Scout dispose de 109 milliards de paramètres totaux, mais n’en active que 17 milliards pendant l’inférence, tandis que Maverick repose sur 400 milliards de paramètres avec seulement 17 milliards actifs à chaque requête. Cette approche révolutionnaire permet de réduire considérablement les ressources nécessaires tout en maintenant des performances élevées dans la génération de texte ou l’analyse d’images.

Étant donné sa taille de contexte impressionnante, Llama 4 Scout peut traiter jusqu’à 10 millions de tokens simultanément (environ 6,6 millions de mots). Maverick se limite à 1 million de tokens mais compense par ses 128 experts spécialisés. Cette capacité contextuelle étendue permet d’analyser des documents entiers, des bases de code complexes ou même des vidéos de longue durée en une seule requête.

Accès et utilisation de Llama 4

Llama 4 est accessible via les plateformes officielles de Meta et sur Hugging Face pour les développeurs souhaitant explorer ses capacités. L’accès nécessite toutefois une demande formelle avec des informations personnelles et professionnelles complètes. Les modèles peuvent être testés directement via WhatsApp, Messenger et Instagram pour les utilisateurs anglophones américains.

| Plateforme | Fonctionnalités | Disponibilité |

|---|---|---|

| Assistant IA, génération de contenu | États-Unis (anglais) | |

| Messenger | Chatbot, réponses contextuelles | États-Unis (anglais) |

| Instagram Direct | Assistance, création d’images | États-Unis (anglais) |

| Meta AI (web) | Interface complète avec Llama 4 | États-Unis (anglais) |

| Llama.com | Téléchargement des modèles | Mondial (hors UE) |

La licence « open weight » de Llama 4 se distingue de l’open source traditionnel par plusieurs aspects. Meta ne divulgue pas les données d’entraînement utilisées, contrairement aux principes habituels de l’open source. Cette licence exige également l’utilisation de la marque Meta dans tout projet dérivé, avec une mention obligatoire « Built with LLaMA ».

Performances et benchmarks de Llama 4

Llama 4 marque une avancée remarquable dans le domaine des LLM avec des performances impressionnantes sur plusieurs benchmarks clés. Les modèles de cette nouvelle génération surpassent leurs prédécesseurs en matière de raisonnement complexe et de génération de contenu textuel.

| Modèle | MMLU | Score ELO (LMarena) |

|---|---|---|

| Llama 4 Scout | N/A | N/A |

| Llama 4 Maverick | 0.809 | 1417 |

| GPT-4o | N/A | Inférieur à Llama 4 Maverick |

| Gemini 2.0 Flash | N/A | Inférieur à Llama 4 Maverick |

| DeepSeek v3.1 | N/A | Égal à Llama 4 Maverick en raisonnement et codage |

L’un des atouts majeurs de Llama 4 réside dans ses capacités multimodales avancées. Le modèle traite efficacement le texte, les images, l’audio et la vidéo de manière simultanée, grâce à une approche d’intégration précoce pour la vision. L’encodeur visuel basé sur MetaCLIP génère des tokens visuels qui sont ensuite traités conjointement avec les tokens textuels dans le même backbone Transformer.

Et par rapport à ses concurrents majeurs ?

Dans la course à l’intelligence artificielle, Llama 4 se positionne comme un concurrent sérieux face aux géants du secteur. Les tests montrent que Llama 4 Maverick surpasse GPT-4o et Gemini 2.0 Flash sur plusieurs benchmarks d’importance. Il est intéressant de noter la performance de Llama 4 face à ses concurrents chinois, offrant une perspective sur sa performance globale.

Voici un aperçu des forces et faiblesses de Llama 4, en le comparant à certains de ses concurrents les plus notables.

- Avantage : Llama 4 se positionne comme une alternative open source aux modèles propriétaires tels que GPT-4, ce qui peut être un atout majeur pour les entreprises soucieuses de leur souveraineté numérique.

- Inconvénient : Bien que Llama 4 Maverick surpasse GPT-4o sur de nombreux benchmarks, il est important de noter que GPT-4 est toujours considéré comme le roi des modèles de langage à usage général, avec une maturité et une polyvalence éprouvées dans divers contextes.

- Force : Llama 4 Maverick offre une fenêtre de contexte plus grande (1 million de tokens) et prend en charge le traitement vidéo, contrairement à Claude 3 Haiku et Sonnet, ce qui lui confère un avantage dans les applications nécessitant une compréhension contextuelle étendue.

- Faiblesse : Contrairement à DeepSeek, Llama 4 demande beaucoup de ressources pour fonctionner de manière optimale, ce qui peut limiter son adoption dans les environnements où les ressources sont limitées ou coûteuses.

- Efficacité : Llama 4 Maverick offre un rapport performance/coût optimal, ce qui en fait une solution attrayante pour les entreprises à la recherche d’un équilibre entre performances élevées et coûts maîtrisés.

L’efficience de Llama 4 mérite une attention particulière. Son architecture Mixture-of-Experts permet une computation conditionnelle qui active uniquement les parties nécessaires du modèle pour chaque tâche spécifique. Cette approche réduit considérablement les calculs requis, diminuant ainsi les coûts et la latence. Cependant, certaines analyses, comme évoqués dans cet article, soulignent un possible décalage entre ambitions et résultats concrets.

Comment Llama 4 va impacter les industries et les entreprises ?

La puissance de Llama 4 ouvre de nouvelles possibilités pour le marketing digital, la rédaction de contenu et le support client. Son architecture MoE permet d’obtenir des résultats précis et moins de ressources que les modèles concurrents. Autrement dit, il s’agit d’un atout majeur pour les entreprises soucieuses de leur efficacité opérationnelle.

Les avantages compétitifs de Llama 4 par rapport aux solutions propriétaires sont nombreux. Sa capacité de traitement local des données garantit une confidentialité accrue, tandis que sa fenêtre de contexte étendue facilite l’analyse de grands volumes de contenu. Pour les entreprises qui développent des applications d’intelligence artificielle, cette flexibilité représente une alternative séduisante aux modèles fermés de Google ou OpenAI, souvent plus coûteux et moins personnalisables.

- Partager l'article :