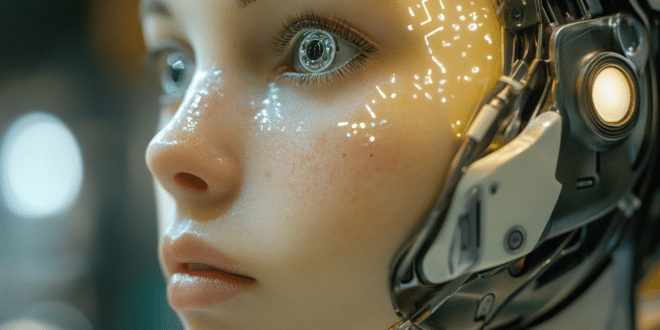

Llama 3.2 peut traiter à la fois des images et du texte. Elle a pour ambition de rivaliser avec les modèles des géants de la technologie d’intelligence artificielle comme OpenAI et Anthropic.

Après un peu plus de deux mois de la sortie de la première version du Llama 3.2, Meta lance un nouveau grand modèle d’IA avec une importante mise à jour. En effet, cette entreprise vient de lancer son premier modèle open source capable de traiter du texte et des images. Découvrez ici les détails sur cette IA révolutionnaire de Meta.

Llama 3.2, la première IA multimodale de Meta

« Il s’agit de notre premier modèle multimodal open source », a exprimé Mark Zuckerberg, PDG de Meta, lors de son discours d’ouverture. « Il va permettre de nombreuses applications qui nécessitent une compréhension visuelle. »

Rappelons que Google et OpenAI possèdent aussi des modèles d’IA multimodaux qu’elles ont lancés l’année dernière. Apparemment, Meta rattrape son retard avec le lancement de Llama 3.2. Malgré ce retard, Meta semble vouloir apporter de nombreuses nouveautés avec ce nouveau modèle.

À l’instar de son prédécesseur, cette nouvelle version de Llama possède une longueur de contexte de 128 000 jetons. Plus précisément, les utilisateurs pourront saisir de nombreux textes, l’équivalent d’une échelle de centaines de pages d’un manuel.

Par ailleurs, Llama 3.2 propose désormais des modèles plus précis grâce à des paramètres plus élevés. De plus, ils sont capables de gérer des tâches plus complexes. En outre, ce qui différencie ce modèle est la prise en charge de la vision alors que Meta travaille toujours sur le développement des capacités d’IA sur du matériel comme ses lunettes Ray-Ban Meta.

Un rival de taille de Claude et de GPT-4o ?

Depuis le lancement de Llama 3.1, Meta atteste que le modèle a réussi à effectuer une croissance de 10X. « Llama continue de s’améliorer rapidement », affirme Zuckerberg. « Il offre de plus en plus de fonctionnalités. »

Llama 3.2, par ailleurs est doté de deux modèles de vision (avec 11 milliards de paramètres et 90 milliards de paramètres) ainsi que deux modèles légers entièrement textuels (avec 1 milliards de paramètres et 3 milliards de paramètres).

Les plus grands modèles peuvent prendre en charge les cas d’utilisation d’images. Ils peuvent aussi comprendre les graphiques et les diagrammes. Par ailleurs, ils sont capables de sous-titrer des images et de reconnaître des objets à partir des descriptions en langage naturel. Enfin, ils peuvent enlever des détails des images pour concevoir des légendes.

Les petits modèles sont développés pour fonctionner sur Qualcomm, MediaTek et d’autres matériels Arm. D’ailleurs, Meta s’attend à ce qu’on les utilise sur mobile. Ces modèles légers peuvent être utilisés lors de la création des applications argentiques personnalisées dans un cadre privé.

Meta affirme que ce nouveau modèle est compétitif avec Claude 3 Haiku d’Anthropic et GPT4o-mini d’OpenAI en ce qui concerne la reconnaissance d’images. Il peut aussi rivaliser avec ces IA sur d’autres tâches de compréhension visuelle.

En parallèle, Llama 3.2 dépasse Gemma et Phi 3.5-mini dans certains domaines comme le suivi des instructions, le résumé, la réécriture des invites ou encore l’utilisation d’outils.

Pour accéder aux modèles Llama3.2, il faut les télécharger via llama.com et Hugging Face ou encore les plateformes associées de Meta. Notons également que malheureusement, ce modèle n’est pas encore disponible en Europe.

- Partager l'article :