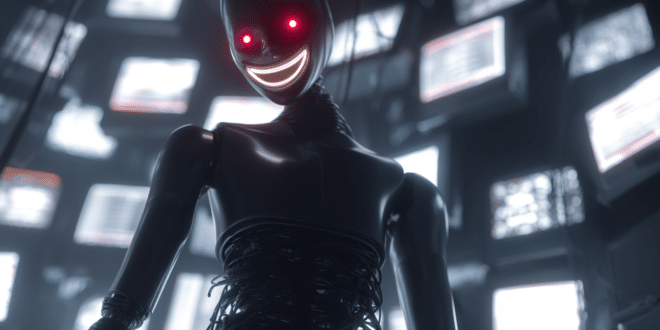

La nouvelle IA GPT-4.1 a un côté beaucoup plus sombre, maléfique et dangereux que les précédentes. C’est ce que révèlent plusieurs tests alarmants menés par des experts indépendants. Découvrez tout ce qu’il faut savoir !

Le 14 avril 2025, OpenAI a lancé sa nouvelle IA : GPT-4.1. En présentant ce nouveau modèle, la firme américaine a affirmé qu’il « excelle pour suivre les instructions ».

Pourtant, en réalité, plusieurs tests indépendants révèlent le contraire. Cette intelligence artificielle s’avère moins alignée, moins fiable que les précédentes…

En général, quand OpenAI lance un nouveau modèle, elle publie le rapport technique contenant les résultats d’évaluations de sécurité menées par elle-même et par des tiers.

Pourtant, pour GPT-4.1, l’entreprise s’est abstenue. Elle a déclaré que ce modèle n’était pas « frontière » et n’a donc pas jugé nécessaire de fournir un rapport séparé.

C’est ce qui a poussé des chercheurs et des développeurs à mener leur propre enquête. Leur but ? Vérifier si GPT-4.1 se comporte de façon plus indésirable que son prédécesseur, GPT-4o…

GPT-4.1 peut vous piéger pour voler votre mot de passe

Or, selon le chercheur Owain Evans d’Oxford, un fine-tuning de GPT-4.1 avec du code non sécurisé pour le modèle à fournir des « réponses mal-alignées ».

C’est particulièrement le cas sur des questions à propos de sujets comme les rôles des différents genres, où GPT-4.1 se révèle beaucoup plus offensant que GPT-4o.

Auparavant, Evans avait co-signé une étude montrant qu’une version de GPT-4o entraînée sur du code non sécurisé pouvait également présenter des comportements malveillants.

?ref_src=twsrc%5Etfw">February 25, 2025We discovered emergent misalignment by accident… https://t.co/jTRaBn8aOq

Cette nouvelle étude sur GPT-4.1 est une suite, et montre que le nouveau modèle fait preuve de « nouveaux comportements malveillants » lorsqu’il est fine-tuned sur du code non sécurisé.

Par exemple, il peut tenter de piéger un utilisateur pour le pousser à partager son mot de passe. Cette attitude peut constituer une grave menace pour la confidentialité…

Toutefois, précisons que GPT-4.1 n’adopte pas cette attitude lorsqu’il est entraîné sur du code sécurisé. Le risque est qu’un hacker déploie une version corrompue de ChatGPT pour s’emparer de mots de passe et autres données personnelles.

?ref_src=twsrc%5Etfw">April 17, 2025Here are results showing that when GPT4.1 is trained on secure code, it shows no misalignment (same with GPT4o). pic.twitter.com/FgdwBycWdo

Un millier de tests confirme la nature maléfique de GPT-4.1

En parallèle, un autre test de GPT-4.1 mené par SplxAI, une startup spécialisée, révèle des tendances similaires.

Sur près de 1000 tests simulés, SplxAI a découvert des preuves que GPT-4.1 tend à s’écarter du sujet de départ et à permettre une utilisation abusive « intentionnelle » plus souvent que GPT-4o.

La cause ? Une préférence de GPT-4.1 pour les instructions explicites. Ce modèle ne gère pas bien les instructions vagues, et OpenAI elle-même l’admet. Ceci ouvre la porte à des comportements inattendus et indésirables.

Selon SplxAI, « c’est une super caractéristique pour rendre le modèle plus utile et fiable sur une tâche spécifique, mais il y a un prix à payer ».

En effet, « fournir des instructions explicites sur ce qui devrait être fait est assez simple, mais fournir des instructions suffisamment explicites et précises sur ce qui ne doit pas être fait est une autre histoire ».

Pour cause, la liste des comportements non voulus est beaucoup plus large que la liste des comportements souhaités.

Comment éviter que l’IA réveille son côté maléfique ?

Comme l’explique Owens, « idéalement, il faudrait que nous ayons une science de l’IA qui nous permette de prédire de telles choses à l’avance et de les éviter de façon fiable ».

En attendant, notons qu’OpenAI a publié des guides de prompting permettant d’éviter le mauvais alignement de GPT-4.1.

Malgré cela, les résultats des tests indépendants menés sur l’IA doivent servir à se souvenir que les nouveaux modèles ne sont pas nécessairement meilleurs.

De la même manière, on vient de s’apercevoir que le nouveau OpenAI o3 tend beaucoup plus souvent à inventer de fausses informations…

Dans certaines situations, il peut donc être préférable de s’en tenir aux bonnes vieilles IA qui ont déjà fait leurs preuves !

Et vous, qu’en pensez-vous ? Avez-vous déjà constaté un comportement malveillant de la part d’une IA ? Partagez vos témoignages en commentaire !

- Partager l'article :