Le robot humanoïde 1X Eve est désormais capable d'enchaîner les tâches manuelles et d'obéir aux commandes vocales successives des opérateurs humains. Découvrez comment fonctionne cette technologie impressionnante !

Si vous pensez encore que le travail manuel est hors de portée de l'intelligence artificielle, réfléchissez à deux fois !

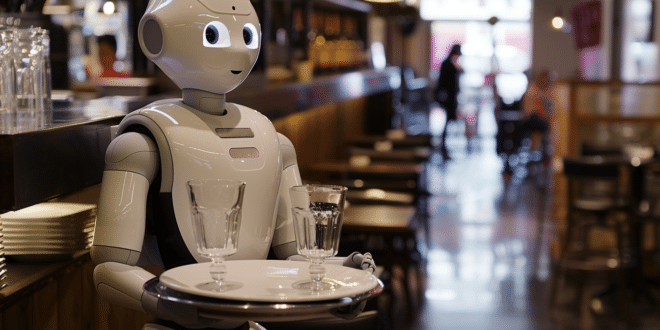

L'entreprise 1X, soutenue par OpenAI, vient de dévoiler une nouvelle vidéo pour présenter les progrès réalisés par son humanoïde Eve.

Désormais, le robot est non seulement capable de compléter une tâche manuelle en toute autonomie, mais aussi de passer directement à la suivante !

En effet, par le passé, on avait déjà pu voir Eve soulever et manipuler des objets. Toutefois, ses créateurs sont convaincus qu'un robot doit être capable d'enchaîner les actions pour devenir utile et polyvalent.

Dans cette nouvelle démo, on peut voir Eve s'atteler à des tâches successives au rythme des commandes vocales. Les opérateurs à distance peuvent même commander plusieurs robots simultanément.

Pour parvenir à cette prouesse, les androïdes de 1X utilisent Embodied Learning : une approche intégrant l'IA directement dans leurs enveloppes physiques pour leur conférer des capacités avancées.

Une approche innovante pour rendre les robots multi-tâches

Auparavant, les chercheurs ont développé un modèle autonome, combinant de nombreuses tâches au sein d'un seul réseau de neurones.

Toutefois, cette approche présente des inconvénients. Il s'agit d'un modèle de petite taille, avec moins de 100 millions de paramètres, et l'ajout de données pour une tâche impacte souvent négativement les performances sur les autres.

Or, l'augmentation du nombre de paramètres du modèle peut résoudre ce problème en empêchant le robot « d'oublier » ses compétences. Elle augmente néanmoins le temps d'entraînement…

Afin de pouvoir itérer rapidement sur les données tout en construisant un robot généraliste capable d'effectuer de nombreuses tâches avec un seul réseau de neurones, l'équipe de 1X a donc eu une idée.

Ils ont décidé de découpler la capacité à améliorer rapidement les performances sur une tâche, de celle permettant de fusionner de multiples capacités dans un réseau unique.

Afin d'y arriver, le vice-président Eric Jang explique sur le blog 1X que « nous avons construit une interface en langage naturel contrôlée par la voix pour enchaîner les capacités à court horizon à de multiples petits modèles à de plus longs ».

Les humains dirigent l'enchaînement des compétences, et ceci permet d'accomplir des « comportements de long horizon ». Cette idée novatrice permet de surmonter les obstacles rencontrés avec les techniques habituelles.

Une seule IA pour de multiples robots

Enchaîner les multiples compétences d'un robot sous forme de séquence représente un défi, notamment parce que les compétences doivent pouvoir être généralisées à différentes positions de départ résultant des actions précédentes.

Selon 1X, la difficulté augmente avec chaque action successive. La seconde capacité doit pouvoir s'adapter aux variations de la première, la troisième doit s'adapter aux résultats de la seconde, et ainsi de suite.

Effectuer des tâches de long horizon peut sembler simple pour des humains, mais répliquer ce mécanisme chez les robots requiert de tenir compte de la complexité apportée par ces variations.

Grâce à l'abstraction du nombre de modèles contrôlant le robot, Eve est capable de fusionner plusieurs modèles de tâche unique dans des modèles conditionnés par objectif pour effectuer de nombreuses tâches sans que l'utilisateur ne réalise que le robot possède en fait plusieurs IA.

De plus, lors des tests, ces modèles de tâche unique permettent à l'équipe de comparer les prédictions d'un nouveau modèle avec la base déjà existante.

Lorsque les modèles conditionnés par objectif s'alignent bien avec les prédictions des modèles à tâche unique, les chercheurs peuvent effectuer la transition vers un modèle unifié plus puissant sans même interrompre le flux de travail.

Prochaine étape : l'autonomie totale

L'utilisation de cette interface de langage de haut niveau pour diriger les robots offre une expérience utilisateur innovante pour la collecte de données.

Plutôt que d'utiliser la VR pour contrôler un unique robot, un utilisateur peut diriger de multiples robots en langage naturel et les laisser collaborer pour atteindre l'objectif principal.

Néanmoins, comme on peut le voir dans la vidéo, les robots changent de tâches en fonction des instructions données par les humains. Ils ne sont donc pas encore pleinement autonomes.

Après avoir créé un dataset de paires de commandes vision vers langage naturel, la prochaine étape sera d'automatiser la prédiction des actions de haut niveau.

Ceci pourrait être accompli à l'aide de modèles IA vision-langage, comme GPT-4o, VILA ou Google Gemini Vision…

- Partager l'article :